“Un ministro francese convocò alcuni dei commercianti più stimati, per chiedere loro suggerimenti sul modo in cui poter sollevare le sorti del commercio, come se intendesse scegliere l’avviso migliore. Dopo che uno ebbe suggerito questo e l’altro quel rimedio, un vecchio commerciante, che fino ad allora era rimasto in silenzio, prese a dire: costruite buone strade, battete buona moneta, accordate uno diritto snello in materia di cambio e così via; quanto al resto, ‘lasciateci fare!’ Questa sarebbe la risposta che dovrebbe dare la facoltà di filosofia, se il governo le chiedesse quali dottrine deve imporre agli studiosi: solo di non impedire il progresso delle idee e delle scienze.“1

1. Il ritorno della qualità

COARA è una coalizione composta promiscuamente da università, enti di ricerca, associazioni scientifiche e agenzie di valutazione che si è formata in seguito all’Agreement on Reforming Research Assessment (ARRA), reso pubblico nel luglio 2022. La coalizione comporterebbe un reciproco impegno a superare o integrare la valutazione amministrativa della ricerca, che è bibliometrica e quantitiva, e a riconoscere la sua qualità e varietà tramite la revisione fra pari.

Secondo un articolo offerto alla revisione paritaria aperta da Francesca Di Donato, che è fra i redattori dell’accordo, per riconoscere la qualità occorrerebbe riaffermare, al modo di Kant, l’autonomia della comunità scientifica. Kant assegnava la ricerca di base alla facoltà di filosofia e trattava la valutazione come intrinseca alla ricerca stessa, se per ricerca si intende “l’esercizio di un metodo che consiste nel sottoporre a critica qualsiasi dottrina, e come tale è presupposto essenziale di ogni conoscenza”. Una valutazione di questo tipo, però, non può svolgersi senza “libere comunità di pari che imparano dai propri errori e si correggono costantemente a vicenda.” Perciò, conclude Francesca Di Donato, per riportare la qualità nella ricerca “non basta cambiare il modo in cui si valuta”: occorre sviluppare un principio dell’accordo ARRA (pp. 3, 5, 6, 9) – quello di coinvolgere la comunità scientifica,  incoraggiandola a “controllare collettivamente le infrastrutture necessarie per il successo della riforma.”

incoraggiandola a “controllare collettivamente le infrastrutture necessarie per il successo della riforma.”

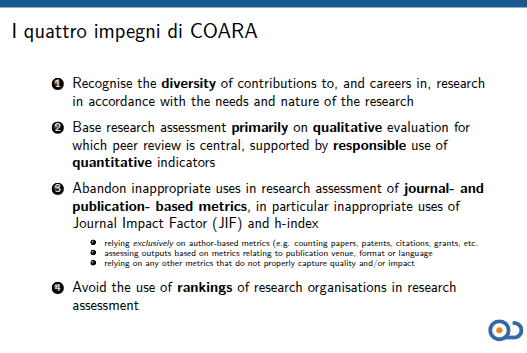

Vale però la pena ricordare che i quattro impegni fondamentali dell’accordo ARRA, riassunti qui a fianco, riguardano il come si valuta. Il coinvolgimento della comunità scientifica è fra gli impegni di sostegno ed è spesso formulato in modo da far pensare che questa possa offrire suggerimenti, di nuovo, sul come si valuta, dando per scontato chi valuta, e dunque la sua legittimazione e la sua assenza di conflitto di interessi. Come recita, per esempio, la spiegazione del punto 6.1 (in traduzione italiana a p. 17, corsivo aggiunto) “questo impegno garantirà che le autorità nazionali / regionali / organizzative e le agenzie di valutazione rivedano e, se necessario, sviluppino criteri per la valutazione delle unità e delle istituzioni di ricerca, in conformità con i Principi”.

2. Valutatori e valutati

L’origine dell’ Agreement on Reforming Research Assessment su cui si basa COARA ha poco a che vedere con Kant. È infatti esito di un’iniziativa che non nasce fra gli studiosi, bensì nella Commissione, con il sostegno del Consiglio dell’Unione Europea, quando la pandemia di Covid-19 mostrò anche ai più conservatori che una valutazione della ricerca basata sulla quantità di pubblicazioni e citazioni non garantisce, come tale, né accessibilità né qualità alla scienza.

Sebbene gli organi dell’Unione Europea abbiano fondato la loro iniziativa su numerosi studi, sia indipendenti sia su commissione, il loro intervento non ha preso di mira le infrastrutture, bensì la qualità della ricerca.

Per riconoscere la qualità di un’opera – ha ammesso l’Unione Europea – bisogna leggerla e comprenderla: per questo una valutazione che la prenda sul serio deve mettere in primo piano la revisione fra pari, compiuta dagli studiosi stessi, e usare la bibliometria in modo “responsabile”. E però il difetto della bibliometria – la pretesa di valutare la ricerca solo quantitativamente, senza leggerla e senza capirla – diventa una virtù, quando la valutazione, strappata alle comunità degli studiosi, è affidata ad agenzie governative centralizzate. La revisione fra pari – si dice – non può essere usata come arma di valutazione di massa perché non è scalabile. La bibliometria invece lo è, proprio perché esonera dalla lettura e dalla comprensione.

Come possiamo dunque sperare di eliminare o ridimensionare l’uso valutativo della bibliometria senza ridimensionare o eliminare le agenzie amministrative centralizzate – quali l’ANVUR italiana e l’ANECA spagnola – a cui il governo ha conferito il compito della valutazione di massa?

COARA, che pure non ammette gli editori scientifici commerciali per il loro evidente conflitto di interessi, non si è posta questo problema: non solo le agenzie statali di valutazione ne possono fare parte, ma possono addirittura sedere nel suo consiglio direttivo. Semplice distrazione o consapevole ambiguità?

Come riferisce Francesca Di Donato il secondo impegno di ARRA richiede che la ricerca sia valutata tramite la lettura e la discussione delle opere dei ricercatori. La revisione fra pari è dunque fondamentale, come parte di un dibattito scientifico pubblico che dovrebbe essere esso stesso oggetto di ricerca, allo scopo di “tenere il meccanismo efficiente e vitale”. Inoltre, il terzo impegno patrocina una “misurazione responsabile”, che prenda congedo “dagli usi inappropriati di indicatori come il fattore d’impatto delle riviste e l’indice H”.

A chi è destinata la ricerca sul dibattito scientifico? Alla riflessione della comunità scientifica o ai valutatori amministrativi per sperimentazioni behavioristiche in corpore vili? Come racconta Melinda Baldwin, negli USA la revisione paritaria chiusa in doppio cieco divenne marchio di scientificità per motivi politici: l’esibizione della procedura permise di sfuggire allo scrutinio del Congresso sui finanziamenti pubblici alla ricerca. Questo arrocco – nella veste di una versione procedurale dell’ipse dixit – non è stato privo di conseguenze, e non solo in termini di conformismo.2 Ma una cosa è un’autocritica della comunità scientifica sul proprio uso pubblico e privato della ragione, un’altra è che funzionari o studiosi-funzionari ne facciano un impiego amministrativo, coinvolgendo, o no, i ricercatori semplici.

3. “Negazionismo bibliometrico”

A chiarire la posizione di COARA, o, almeno, di chi la guida, ha aiutato la recente accusa di “negazionismo bibliometrico”, a cui Luciana Balboa, Elizabeth Gadd, Eva Mendez, Janne Pölönen, Karen Stroobants, Erzsebet Toth Cithra e l’intero consiglio direttivo di COARA si sono affrettati a rispondere cosi:

Usare solo la scientometria per valutazioni a livelli di granularità più bassi, cioè per la valutazione degli individui, che comprende scopi importanti quali l’assegnazione di riconoscimenti (finanziamenti, posti di lavoro), è altamente problematico. In casi come questi si dovrebbe preferire la revisione paritaria.

Tuttavia

l’uso della scientometria a livelli di aggregazione superiori, come quello nazionale o universitario, e per forme di valutazione meno importanti come la conoscenza scientifica, è molto meno problematico (anche se ancora imperfetto).

La loro risposta mostra anche la consapevolezza della difficoltà di tener confinata la bibliometria a livelli superiori. Un ricercatore che si trova a lavorare in un’istituzione valutata e finanziata con criteri quantitativi sarà spinto a orientarsi bibliometricamente, a dispetto di tutti gli impegni a farne un uso responsabile.

Resta il fatto che una dipendenza eccessiva da una scientometria pur responsabile può comunque avere un impatto negativo, per trascinamento, sull’ecosistema della valutazione della ricerca. Un uso legittimo della bibliometria per comprendere l’attività a livello di paese può velocemente estendersi ai criteri di promozione, se, a livelli di aggregazione superiori, si associa alla valutazione bibliometrica un riconoscimento troppo grande.

La risposta rende chiaro che COARA non intende eliminare le armi di valutazione di massa e le agenzie statali che ne fanno uso, bensì solo limitarne il danno. Quanto all’effetto trascinamento (trickle-down) la soluzione – si dice – può essere il principio 9 del Leiden Manifesto for the responsible use of bibliometrics, il quale suggerisce di adottare “un insieme di indicatori” invece che “uno solo”, in modo da render difficili la manipolazione (gaming) e la trasformazione dell’indicatore in obiettivo.

Se non ci accontentiamo di soluzioni “soluzioniste”, dobbiamo però ricordare che è così facile manipolare il sistema perché gli indicatori bibliometrici sono connessi solo ortogonalmente alla qualità della ricerca, anche se sono indispensabili alle burocrazie valutatrici centralizzate, munite o meno di programmi per computer, perché incapaci di leggere e comprendere la scienza non solo come è scritta, ma anche com’è fatta. I ricercatori non sono necessariamente più truffaldini del resto della popolazione: semplicemente, sono esposti alla tentazione di truccare il sistema per amor di carriera o di mera sopravvivenza accademica proprio perché sottomessi a criteri di valutazione che non afferrano la sostanza della scienza. La prima manipolazione del sistema, in altre parole, è il sistema stesso.3

E il sistema è anche, letteralmente, un sistema di sottomissione: chi guida COARA si è sentito in dovere di rispondere a critici che non parlano come ricercatori che si rivolgono a colleghi, ma con i toni del padrone, o del consulente del padrone, che vede gli studiosi come risorse il cui uso va ottimizzato.

Nel ventunesimo secolo, patrocinare una valutazione della ricerca basata sulla revisione paritaria invece che su metodi scientometrici appare obsoleto e controproducente. Da decenni si va perseguendo una costante innovazione tecnologica trainata dalla necessità di ottimizzare risorse limitate quali gli scienziati. La ricerca scientometrica conduce a soluzioni più efficienti ed economiche per valutare la ricerca e soddisfare le esigenze degli utenti.4

Anche se COARA, come pare, mira solo alla riduzione del danno, l’ammissione delle agenzie di valutazione non solo alla coalizione ma al suo stesso consiglio direttivo mette a rischio pure questo modesto obiettivo: le agenzie di valutazione di massa, avendo bisogno di armi di valutazione di massa, portano con sé un enorme conflitto di interessi, che può condurre – come mostra il caso italiano5 – l’intrapresa al fallimento.

4. Qualità e libertà

La valutazione fra pari, anche in COARA, è legata, come discussione idealmente libera e accessibile, alle pratiche della scienza aperta – pratiche che numerose istituzioni politiche si sono date la pena di definire e raccomandare. In un ambiente addomesticato dalla valutazione amministrativa questi interventi inducono a trattare l’open science come uno dei tanti adempimenti richiesti agli addetti alla ricerca, spesso pensati senza neppure una particolare lungimiranza.

Per esempio, nel 2015 la Commissione europea rappresentava la scienza aperta (p. 33) così: “L’ Open Science è un cambiamento tanto importante e dirompente quanto l’e-commerce per la vendita al dettaglio”. Era già, allora, chiaro che il cosiddetto platform capitalism stava esponendo il web pubblico a privatizzazione, monopolio e sfruttamento: nel 2010 lo stesso inventore del web, Tim Berners-Lee, aveva già lanciato il suo allarme. Ma la Commissione europea inseriva spensieratamente nell’ecosistema della scienza aperta (p.39) piattaforme proprietarie come Academia.edu o Mendeley, acquistata da Elsevier nel 2013.

Oggi è diventato facile criticare la scienza di stato, quando viene stabilita per decreto oltreoceano. Ma non si tratta di qualcosa di nuovo, spuntato nottetempo come un fungo: anche se riducessimo a periferica la valutazione di stato italiana, non possiamo trattare come tale l’interferenza dell’Unione Europea nelle modalità e nelle valutazioni della scienza – a dispetto di un Kant molto invocato e poco letto.

La rivoluzione scientifica moderna, dal canto suo, non nacque da prescrizioni di monarchi e di despoti illuminati. Secondo Paul David, l’idea della scienza come bene comune, basata sulla collaborazione e finanziata da mecenati aristocratici, si radica in un mondo pre-capitalistico e assai meno burocratico. Se vogliamo allentare la morsa della burocrazia che priva la ricerca di qualità, non possiamo concepire l’apertura come un compito amministrativo. Infatti, l’obiettivo non è quello di devolvere risorse in pubblicazioni a pagamento per i profitti o le rendite private,6 ma di mantenere o ricreare le condizioni che consentono alle comunità scientifiche di curarsi della qualità del loro lavoro attraverso la collaborazione e la critica libera.

5. Qualità: una definizione sfuggente

Secondo Wilhelm von Humboldt, la cui riforma universitaria è stata per lo più smantellata dall’Unione Europea tramite il cosiddetto processo di Bologna, è “caratteristica degli istituti scientifici superiori continuare a trattare la scienza come un problema ancora non del tutto risolto e perciò rimanere sempre alla ricerca”. Anche per questo – non solo perché non sappiamo concepire un criterio universale di verità – la definizione di qualità è così elusiva.

Nel linguaggio aziendale la qualità consiste in parametri rigorosamente definiti a cui si devono adeguare prodotti e processi. La qualità della ricerca, però, non essendo riducibile a standard amministrativamente accertabili, può essere meglio indagata a partire da un testo eccentrico: Lo Zen e l’arte della manutenzione della motocicletta di Robert M. Pirsig.

Nel libro l’alter ego di Pirsig a Bozeman, Fedro, prova in primo luogo a trattare la qualità non come una questione teoretica, bensì pragmatica. Il docente abolisce i voti e chiede agli studenti di valutare i loro compiti da sé, giorno per giorno. Alla fine scopre che gli studenti tendono all’imitazione reciproca e dell’insegnante. Non è una sorpresa: se ci si affida alla pratica senza nessuna riflessione teoretica si otterrà soltanto una moda, i cui capricci sono imitabili ma irriducibili a concetto.

Paradossalmente, questo è anche il peccato originale della valutazione bibliometrica della ricerca: perché cercare l’inafferrabile e non scalabile qualità quando si può facilmente calcolare, tramite le citazioni, quanto va di moda?

Il metodo scientifico, per Pirsig, è il modo in cui esseri razionali ma finiti selezionano una singola (e forse provvisoria) verità tra molte ipotesi, pur senza essere in grado di afferrare la Verità in generale. E nell’uso di questo metodo – che è diverso dall’annotazione amministrativa dell’impatto di qualcosa che non ci si cura di capire – si manifesta, di volta in volta e provvisoriamente, la qualità. Per cogliere il senso di questo processo, però, bisogna farne parte, cioè essere ricercatori e non burocrati che, più o meno “responsabilmente”, registrano l’“impatto” di qualcosa che rimane loro oscuro. Questa tesi non va interpretata come una mistica della ricerca: semplicemente, quando adottiamo criteri “statici” di qualità per valutazioni puntuali quali concorsi e assunzioni, dobbiamo essere consapevoli che non sono in grado di render giustizia all’intero processo, che non è statico ma dinamico.7

Pertanto, come Kant sostenne nel Conflitto delle facoltà, ridurre le università a istituzioni ministeriali sottomesse a criteri di verità interamente estrinseci e amministrativamente applicati, mette a repentaglio la credibilità stessa della scienza. La credibilità scientifica, infatti, non dipende dall’adesione a parametri bensì dalla libertà della critica pubblica, proprio perché si forma entro un processo non terminato e non terminabile. Questa libertà degli studiosi, che è condizione della scienza, non consiste in una facoltà di dare ordini, bensì nella possibilità di mettere in discussione anche gli studiosi-funzionari al servizio dell’amministrazione – criteri amministrativi di valutazione compresi. Perciò

6. L’Unione Elusiva

Per Kant l’economia interna dell’università richiede, in primo luogo, la libertà. I politici, da parte loro, dovrebbero occuparsi delle infrastrutture della ricerca e non del modo in cui i ricercatori la fanno. Caesar non est supra grammaticos.

Molti tecnocrati europei, quando si tratta di appellarsi ai “nostri valori”, amano o amavano presentarsi, a proposito o a sproposito, come kantiani. Ma l’accordo ARRA e COARA non possono dirsi tali se non propagandisticamente.

- La Commissione europea scopre, sia pure in grave ritardo, che la valutazione quantitativa della ricerca produce quantità e non qualità.

- Per risolvere il problema promuove una coalizione lasca di università, istituzioni di ricerca, società di studi e agenzie di valutazione, anche centralizzate, con lo scopo di riformare la valutazione della ricerca, come se il dominio della bibliometria e il danno alla qualità della ricerca fosse esito esclusivo di iniziative venute dai ricercatori, che vanno incoraggiati ad autocorreggersi.

Un politico kantiano avrebbe fatto esattamente l’opposto.

- In primo luogo, avrebbe lasciato la valutazione della ricerca ai ricercatori.

- In secondo luogo, avrebbe indagato sulle eventuali condizioni infrastrutturali – le buone strade, la buona moneta, lo snello diritto di cambio della citazione in epigrafe – che un’azione politica avrebbe potuto migliorare. E non avrebbe fatto fatica a scoprire che la bibliometria, come arma di valutazione di massa, è indispensabile dove la valutazione è amministrativa e centralizzata – come in Italia con l’ANVUR e in Spagna con l’ANECA. E avrebbe usato la sua autorità legislativa per eliminare o ridurre al minimo questo tipo di valutazione. “Quanto al resto, lasciateci fare!”

L’iniziativa politica europea si è invece concentrata, soluzionisticamente, sul come si valuta non solo senza chiedersi chi valuta, ma anche dando per scontata la legittimità delle agenzie di valutazione statali e soprattutto che queste, ammesso e non concesso che siano indipendenti, possano seriamente impegnarsi a minimizzare o abolire le armi – bibliometriche – di valutazione di massa e quindi a ridimensionare o abolire se stesse. Così il peccato originale della sovrapposizione di potere amministrativo e ricerca continua ad affliggere COARA, senza che l’UE, in veste di Unione Elusiva, abbia il cervello e il cuore di redimerlo.8

- I. Kant, Il conflitto delle facoltà, AK VII, 19-20 n2, traduzione di Domenico Venturelli (Brescia : Morcelliana, 1994), con qualche modifica. ↩︎

- Ha, infatti, reso facile sostenere che qualsiasi pretesa è “scientifica” perché pubblicata su una rivista a revisione paritaria (Adam Marcus, Ivan Oransky. “The Scientific Literature Can’t Save You Now”. In: The Atlantic (2025) https://www.theatlantic.com/science/archive/2025/02/rfk-kennedy-vaccines-scientific-literature/681681/ ↩︎

- “Rather than serving as a scientific certification process, administrative evaluation functions as a mechanism for ascribing value to research outputs and contributions based on criteria established by administrative or policy authorities”: Alberto Baccini, COARA will not save science from the tyranny of administrative evaluation, https://arxiv.org/abs/2408.05587v3, 2025, §6. ↩︎

- Giovanni Abramo, The forced battle between peer-review and scientometric research assessment: Why the CoARA initiative is unsound, 2024. ↩︎

- Come mostra, per quanto concerne l’Anvur, la distanza fra gli impegni sottoscritti e quelli programmati. ↩︎

- Come nei conservativi accordi trasformativi, finiti un vicolo cieco. ↩︎

- Per esempio la discussione fra matematici può essere documentata da pubblicazioni che in passato erano riviste e ora, come mostra il caso Perel’man, un archivio istituzionale ad accesso aperto. ↩︎

- Anche perché i suoi consulenti più rispettati, ancorché non eletti (The Future of European Competitivenss: A competitiveness strategy for Europe (Part A) 2024), deplorando che poche università europee raggiungano “top levels of excellence” (eccellenza misurata, a dispetto di COARA, sulla base del volume di pubblicazioni in “top academic journals”, p. 24) e pesando il valore della ricerca pubblica in base alla sua capacità di privatizzarsi in brevetti (p.25), trattano i ricercatori come risorse da spremere per estrarne “innovazione” (p.24) senza mai chiedersi se a renderli conformisti non sia proprio la servitù amministrativa a cui sono sottomessi. ↩︎

Rendiamo disponibile il

Rendiamo disponibile il

Paola Galimberti ha reso pubblico su Zenodo.org un breve articolo,

Paola Galimberti ha reso pubblico su Zenodo.org un breve articolo,

RSS 2.0

RSS 2.0 Mastodon

Mastodon

Ultimi commenti