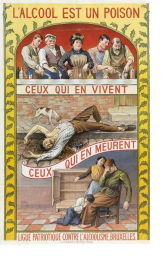

L’Unione Europea ha patrocinato la formazione di COARA, una coalizione composta promiscuamente da università, enti di ricerca, associazioni scientifiche e agenzie di valutazione, con lo scopo di limitare la bibliometria a un uso responsabile. Ha avuto cura di escludere dalla coalizione, perché in conflitto di interessi, gli editori commerciali, che in una lega per la temperanza farebbero la parte dei produttori di alcolici, ma non le agenzie della valutazione di stato o comunque amministrativa, che farebbero la parte delle osterie. Ma mentre nelle osterie che spacciano spirito si va liberamente, quelle che impongono bibliometria di stato come arma di valutazione di massa sono a frequentazione coatta e, in una lega per la sobrietà bibliometrica, in radicale conflitto di interessi.

Per quanto, come spiega l’articolo di Francesca Di Donato di cui questo intervento è una revisione paritaria aperta, sarebbe stato possibile sviluppare creativamente i principi di COARA in senso kantiano, la riforma, in Italia, sta risultando poco incisiva. La responsabilità è anche dell’UE, la quale, in veste di Unione Elusiva, ha dato antikantianamente indicazioni su come si valuta senza chiedersi chi valuta, e dunque senza toccare la valutazione amministrativa – il che è come promuovere una campagna per la sobrietà fra i bevitori lasciando aperte le osterie di stato a frequentazione coatta e addirittura permettendone la collaborazione.

Come l’omino di burro del romanzo di Collodi, chi introduca nelle scuole e nelle università strumenti di “intelligenza artificiale generativa”, promette agli studenti un Paese dei Balocchi in cui potranno scrivere senza aver pensato.

I sistemi neoliberali – nei quali si ritiene che la didattica sia un addestramento ai test e che la valutazione delle opere dei ricercatori non ne richieda la lettura – sono già pronti a un simile annientamento dell’istruzione pubblica e alla sua sostituzione con qualche software proprietario.

La scienza cosiddetta aperta – o, almeno, la sua retorica – è sembrata una soluzione alla delegittimazione della ricerca istituzionale contemporanea: “crisi di trasparenza, di riproducibilità, di accesso, di fiducia pubblica”.

L’esperienza italiana, di cui si occupa il contributo di Paola Galimberti che presentiamo qui, mostra però che una cosa è fare dichiarazioni, un’altra scalfire interessi e poteri sedimentati per sostenere infrastrutture nazionali condivise, politiche di finanziamento stabili, sistemi informativi e di monitoraggio aperti. E prima di concludere che l’immobilità del sistema è dovuta solo a povertà di denaro, bisogna considerare quanto se ne è versato e se ne continua a versare agli oligopolisti dell’editoria commerciale.

D’altra parte, quando si è trattato di recepire l’invito europeo a rendere la ricerca “sicura”, il governo italiano si è invece affrettato a battere i tacchi. Come mai?

Daniela Tafani has made her contribution, accepted for the Kant-Congress 2024, “The sole palladium of the people’s rights”. Freedom of the pen as a counterpower in Kant and his contemporaries, available on Zenodo.

For Kant’s contemporaries, his claim that the “freedom of the pen” is “the only palladium of the people’s rights” represented a clear political stance that favoured the thesis of the people’s sovereignty and the inalienable individual right to judge the actions of the constituted power.

As Kant and French revolutionaries knew, to claim the freedom of the press is to claim the power of the people to monitor the power of the State, judge it and, ultimately, overturn it.

So-called ‘AI’ is a derivative of a surveillance business model that allows Big Tech to provide extrajudicial surveillance services for both civil and military purposes. As such mass surveillance is banned, Big Tech, through regulatory capture, has produced the AI Act, under which fundamental rights can be violated with impunity as long as there is no foreseeable harm. So Big Tech’s next target is any norm that still protects fundamental rights.

The attacks on the GDPR are sneaky attacks on the fundamental rights that the GDPR protects, not attacks on the alleged obstacles that stifle innovation.

On this neoliberal attack on fundamental rights, Daniela Tafani submits to open peer review her article, GDPR could protect us from the AI Act. That’s why it’s under attack.

RSS 2.0

RSS 2.0 Mastodon

Mastodon

Ultimi commenti